咨询电话

400-123-4567

手 机:13988999988

电 话:400-123-4567

传 真:+86-123-4567

邮 箱:[email protected]

地 址:广东省广州市天河区88号

电 话:400-123-4567

传 真:+86-123-4567

邮 箱:[email protected]

地 址:广东省广州市天河区88号

微信扫一扫

从“做事”到“逻辑扣除”,如何防止大型模型

作者:365bet登录日期:2025/05/03 10:00浏览:

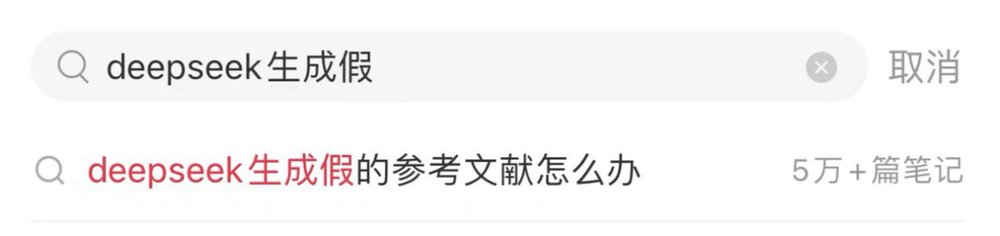

制作虚假的文件,理由是不存在名人意见,制作错误的数据,将旧事物传播为新闻...发展看似合理但基于不完整的信息确实是错误的答案,因此很难识别真实性。这种现象称为行业的“ AI幻觉”。 “ AI幻觉”是一个隐藏的缺陷,在大型模型中自然存在。特别是在互联网上,大型模型只能在推理中寻求内容,不能像人类一样判断现实,并且对信息本身的真实性不承担任何责任。 4月25日,Baidu AI开发人员会议上的Robin Li承认,DeepSeek具有许多幻觉和缓慢的步伐,并再次将“ AI幻觉”的概念带入了公众的愿景。 Thethis Litang于2023年初在互联网上表达,但仍以当今社会的主要平台上的具体术语显示。例如,在Xiaohongshu平台上这里有50,000个相关帖子与“如果Deptseek产生伪造的参考”有关的帖子;在微博中,#shods的主题是防止DepSeek随机编制文档的主题,也已成为热门搜索。此外,有些人依靠人工智能在没有判断力的情况下进行“捷径”,相关争议仍在继续。在AI浪潮下,如何在保护自己的思维能力的同时将其视为相同的准确性和效率?破解AI的幻想并打开新的“ AI +教育”实施情况。面对大型AI模型“严重胡说八道”。如果您需要避免被欺骗,一方面,您需要正确查看AI生成和输出的内容,另一方面,您应该以良性的方式与AI联系,而不是完全接受其输出结果。中华民国新闻学院的教授卢·吉宁(Lu Jiinin)指出,这种现象在发展知识和发展方面有两个隐藏的风险发展:就知识构建而言,AI发展的错误学术成就会破坏对年轻人的理解,并介绍他们的尖叫丑闻并使青少年成为丑闻。 “假设验证”科学实践。在发展思维方面,AI谣言通过算法推荐的“ Cocoon信息”形成了逻辑上的闭环,这在批判性思维的培养中并不令人愉快。因此,应将AI的输出内容视为理解的起点,而不是观点的终点。我们需要积极验证信息可靠性,例如审查强大的资源,比较不同的观点,甚至直接与现场专家交谈。除了仔细使用大型模型外,Coolcai还探索了实施该方案的“ AI +教育”的另一条路径,以实现大型模型,以执行计划和计划,即大型模式L将首先拆卸并研究问题,然后调用适配器工具来解决问题。这个想法已在Cookai AI学习机Y41空气中得到证明,该空气配备了NG Intellion教育。从“答案工具”到“思维助手”,一个人工智能问题如何正确教授?真正具有“人类品味”的AI教育始于对技术界限的清晰了解。 Kukai需要做的就是使AI成为“思考助手”,而不是用于回答问题的“工具”。配备了Cookai AI学习机Y41空气的教育代理摧毁了通用模型一般通用的数据泛化问题。在整个研究的整个阶段,通过在K12的银行中纳入10亿级的扣除额,它使用大量基本数据来防止“不想像力”的推理,并结合了从底部解决大型模型的准确性和解释。当学生问一个问题时,学习NG机会遵循“首先比赛,然后推断”的双轨逻辑。首先,准确地将相同类型的问题对应到大量的问题,然后通过大型模型减少问题解决路径,以降低来自来源的AI幻觉的风险。在初中获得几何问题,例如,Y41就像私人“导师”的AI-Study Air机器,不仅提供答案和完整的推理过程,而且还使用一对一的问题指南来鼓励学生观察图形特征,并自由地减少辅助线以添加逻辑来添加逻辑来添加logic logic添加logic logic。这种在解决问题的过程中结合了个性化互动指导的设计不仅可以改善SA模仿人类计算机接触的感觉,而且还致力于培养学生的思维能力,以积极思考和研究,与传统的AI Q Q构成重要区别Uestion工具。目前,AI教育站在人口应用的十字路口上。 Cookai研究机提供的技术路径表明,解决AI的幻想的风险不仅仅依赖于模型优化,而且还需要从教育本质的角度重建人机关系。在AI和教育深入整合的过程中,如何平衡技术能力和教育逻辑,Coolcao的技能给出了适当关注的答案。

制作虚假的文件,理由是不存在名人意见,制作错误的数据,将旧事物传播为新闻...发展看似合理但基于不完整的信息确实是错误的答案,因此很难识别真实性。这种现象称为行业的“ AI幻觉”。 “ AI幻觉”是一个隐藏的缺陷,在大型模型中自然存在。特别是在互联网上,大型模型只能在推理中寻求内容,不能像人类一样判断现实,并且对信息本身的真实性不承担任何责任。 4月25日,Baidu AI开发人员会议上的Robin Li承认,DeepSeek具有许多幻觉和缓慢的步伐,并再次将“ AI幻觉”的概念带入了公众的愿景。 Thethis Litang于2023年初在互联网上表达,但仍以当今社会的主要平台上的具体术语显示。例如,在Xiaohongshu平台上这里有50,000个相关帖子与“如果Deptseek产生伪造的参考”有关的帖子;在微博中,#shods的主题是防止DepSeek随机编制文档的主题,也已成为热门搜索。此外,有些人依靠人工智能在没有判断力的情况下进行“捷径”,相关争议仍在继续。在AI浪潮下,如何在保护自己的思维能力的同时将其视为相同的准确性和效率?破解AI的幻想并打开新的“ AI +教育”实施情况。面对大型AI模型“严重胡说八道”。如果您需要避免被欺骗,一方面,您需要正确查看AI生成和输出的内容,另一方面,您应该以良性的方式与AI联系,而不是完全接受其输出结果。中华民国新闻学院的教授卢·吉宁(Lu Jiinin)指出,这种现象在发展知识和发展方面有两个隐藏的风险发展:就知识构建而言,AI发展的错误学术成就会破坏对年轻人的理解,并介绍他们的尖叫丑闻并使青少年成为丑闻。 “假设验证”科学实践。在发展思维方面,AI谣言通过算法推荐的“ Cocoon信息”形成了逻辑上的闭环,这在批判性思维的培养中并不令人愉快。因此,应将AI的输出内容视为理解的起点,而不是观点的终点。我们需要积极验证信息可靠性,例如审查强大的资源,比较不同的观点,甚至直接与现场专家交谈。除了仔细使用大型模型外,Coolcai还探索了实施该方案的“ AI +教育”的另一条路径,以实现大型模型,以执行计划和计划,即大型模式L将首先拆卸并研究问题,然后调用适配器工具来解决问题。这个想法已在Cookai AI学习机Y41空气中得到证明,该空气配备了NG Intellion教育。从“答案工具”到“思维助手”,一个人工智能问题如何正确教授?真正具有“人类品味”的AI教育始于对技术界限的清晰了解。 Kukai需要做的就是使AI成为“思考助手”,而不是用于回答问题的“工具”。配备了Cookai AI学习机Y41空气的教育代理摧毁了通用模型一般通用的数据泛化问题。在整个研究的整个阶段,通过在K12的银行中纳入10亿级的扣除额,它使用大量基本数据来防止“不想像力”的推理,并结合了从底部解决大型模型的准确性和解释。当学生问一个问题时,学习NG机会遵循“首先比赛,然后推断”的双轨逻辑。首先,准确地将相同类型的问题对应到大量的问题,然后通过大型模型减少问题解决路径,以降低来自来源的AI幻觉的风险。在初中获得几何问题,例如,Y41就像私人“导师”的AI-Study Air机器,不仅提供答案和完整的推理过程,而且还使用一对一的问题指南来鼓励学生观察图形特征,并自由地减少辅助线以添加逻辑来添加逻辑来添加logic logic添加logic logic。这种在解决问题的过程中结合了个性化互动指导的设计不仅可以改善SA模仿人类计算机接触的感觉,而且还致力于培养学生的思维能力,以积极思考和研究,与传统的AI Q Q构成重要区别Uestion工具。目前,AI教育站在人口应用的十字路口上。 Cookai研究机提供的技术路径表明,解决AI的幻想的风险不仅仅依赖于模型优化,而且还需要从教育本质的角度重建人机关系。在AI和教育深入整合的过程中,如何平衡技术能力和教育逻辑,Coolcao的技能给出了适当关注的答案。相关文章

- 2025/05/15游戏杀死哪个很有趣?前十名应该玩谋杀

- 2025/05/14揭示了文件夹软件如何保护文件的秘密

- 2025/05/13在“国民服务”的第一天,在各省和城市

- 2025/05/12小米Mijia冰箱三扇门216升新发射产品:五